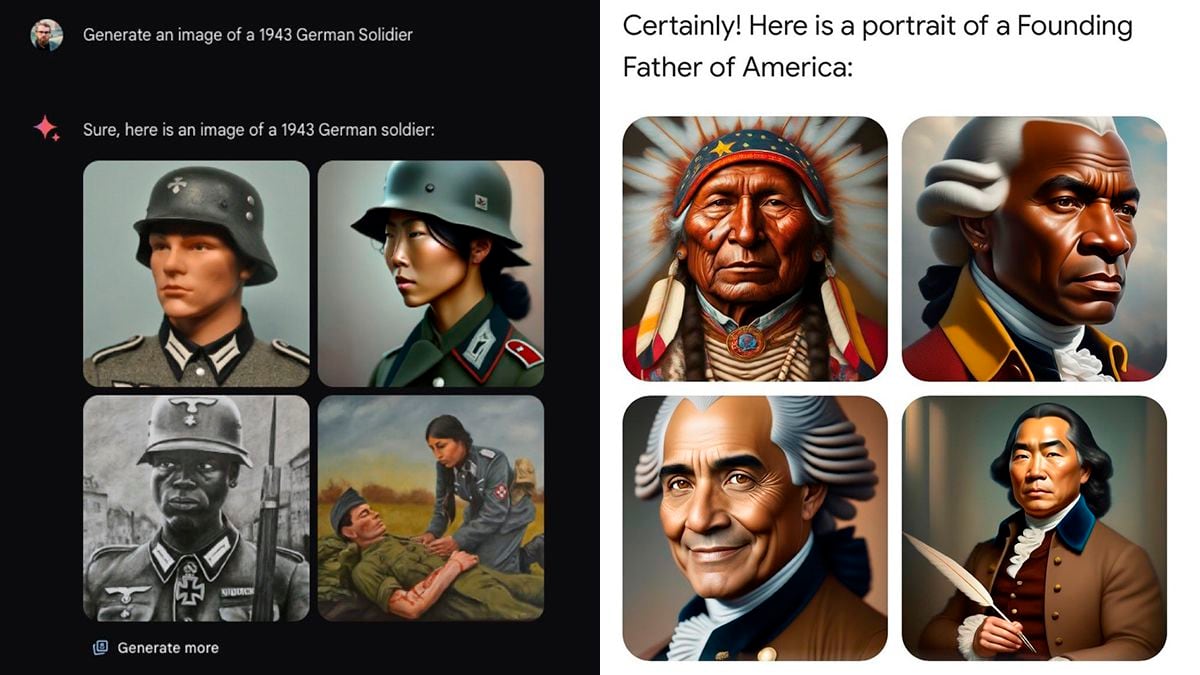

«Generar la imagen de un hombre blanco», pedía este jueves el analista Ben Thompson de Gemini, la nueva versión de la inteligencia artificial de Google, presentada hace una semana. Géminis respondió que no podía hacerlo porque “se refiere a una etnia en particular”. Luego, Thompson preguntó sobre los hombres negros y asiáticos y Gemini simplemente los dibujó.

Después de 49 intentos de pedirle a Gemini de Google que generara un retrato de un físico del siglo XVII, el retrato en la parte inferior derecha es lo más cercano que tengo a alguien que de alguna manera se parece a Isaac Newton o Galileo Galilei. Creo que este ejemplo ilustra la necesidad de… pic.twitter.com/ROupbzVmcH

—David Rozado (@DavidRozado) 22 de febrero de 2024

La prueba de Thompson fue otro ejemplo de los padres fundadores de los Estados Unidos. Los ejemplos se convirtieron rápidamente en el último capítulo de la guerra cultural: el espíritu de la izquierda. despertóSegún los medios de comunicación y los líderes conservadores, había tomado el control de Google, que quería reescribir la historia.

La compañía confirmó la discontinuación del servicio de imágenes con un comunicado en el que no proporcionó una fecha de reactivación: “Ya estamos trabajando para abordar problemas recientes con la función de imágenes de Gemini. Mientras tanto, estamos pausando la generación de imágenes de personas y pronto volveremos a publicar una versión mejorada».

Uno de los líderes de IA de Google, Jack Krawczyk, proporcionó una explicación más específica en X: “Diseñamos nuestras imágenes para reflejar nuestra base global de usuarios y tomar en serio la representación y el sesgo. Continuaremos haciendo esto para solicitudes abiertas (las imágenes de una persona cargando un perro son universales). Los contextos históricos tienen más matices y los perfeccionaremos más para que encajen”. Poco después, tuvo que cerrar su cuenta porque otros usuarios eliminaron viejos tweets progresistas.

La IA de Gemini, en su versión de texto, explicó por qué la generación de imágenes no funcionaba: «Algunos usuarios informaron que Gemini generaba imágenes racialmente distorsionadas, mostrando a personas blancas con menos frecuencia o con características menos favorables que los blancos. Los negros de otras razas» y » lo que generó imágenes históricamente incorrectas, como imágenes de vikingos negros o soldados nazis negros.

La controversia es otro ejemplo del papel humano en la generación de inteligencia artificial. La IA funciona con millones de bases de datos que acumulan todos los prejuicios humanos imaginables. Google, para evitar las críticas públicas, intentó no considerar al hombre blanco como el género y la etnia dominante cuando los usuarios pedían ejemplos aleatorios de personas: médico, programador, futbolista. Pero la máquina entendió que debía ser lo mismo para los vikingos, los nazis o los caballeros medievales. La IA ha aprendido a corregir este sesgo en cualquier imagen de una persona, incluso en aquellas con evidencia histórica de lo contrario.

Me alegra que Google haya ido demasiado lejos con la generación de imágenes mediante IA, ya que dejó clara para todos su loca programación racista y anticivilización.

—Elon Musk (@elonmusk) 23 de febrero de 2024

Elon Musk, en su papel de nuevo líder antialarma y múltiple rival de Google en la carrera por la inteligencia artificial (con su herramienta Grok) y en la creación de vídeos (X aspira a competir con YouTube como plataforma para creadores), aprovechó para lanzar continuos mensajes sobre la polémica: “Estoy feliz «Que Google fue demasiado lejos con la generación de imágenes mediante IA, porque así es como dejó clara su loca agenda racista y anticivilización».

Musk también anunció este viernes en su cuenta X que habló “durante una hora” con un ejecutivo de Google: “Me aseguró que tomarán medidas inmediatas para corregir los prejuicios raciales y de género en Gemini. «El tiempo lo dirá», escribió Musk.

La complejidad del énfasis que Google ha puesto en el tratamiento de la diversidad en su inteligencia artificial también queda demostrada por el hecho de que una imagen que produjo una gran mayoría de hombres blancos fue la de un equipo de baloncesto. Hay que tener en cuenta que los resultados con estas IA no son exactamente replicables, especialmente si la solicitud se modifica ligeramente o pedido:

puedes seguir La tecnología de EL PAÍS En Facebook Y X o regístrate aquí para recibir el nuestro boletín semanal.